*

우도에서 크로스엔트로피까지 유도를 한번 해 보자.

•

𝑃(𝑌|𝑋;θ) (likelihood, 우도) 를 최대화하는 θ를 찾자. = maximum log likelihood 를 찾자.

•

를 최대화하는 를 찾자.

◦

예시** 를 참고하면, 과 같은 형태일 것이다.

•

를 최대화하는 를 찾자. (그냥 로그 씌운거임. 로그는 x>0 에서 1:1 대응이므로)

◦

이를 로그우도라고 한다.

•

기댓값의 수학적 정의는

•

를 최대화하는 를 찾자. (기댓값 폼 으로 바뀐 것)

◦

이를 로그우도의 기댓값이라고 한다.

◦

이때 이 무엇인가 보면 또 재미있다.

▪

◦

이것을 풀어 쓰면 이다. 이러면 조금 더 기댓값같나?

•

를 최소화하는 를 찾자.

◦

이를 "음의 로그우도 기댓값" 이라고 한다.

◦

이 식을 조금만 더 다르게 바꿔 본다면 와 같이 나타낼 수 있고

◦

이것은 정보이론의 크로스-엔트로피의 이산변수 버전의 식과 일치하게 된다.

◦

이를 두 확률분포의 관점으로 쓰면 이다.

◦

**

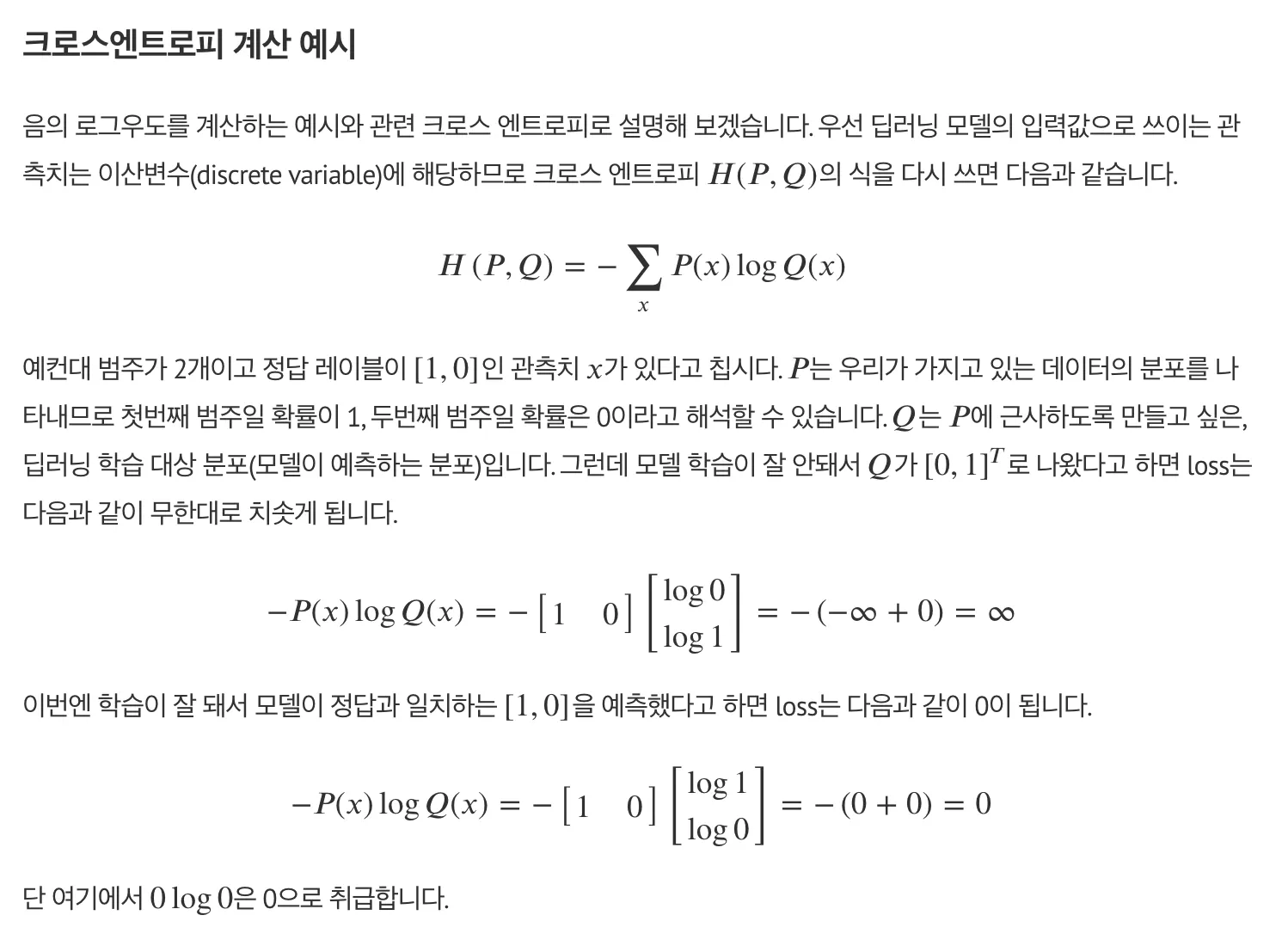

예를 들어 생각해 보니 추상적인 개념이 조금 더 구체저으로 와닿는 기분이었다.

만약 범주가 10개인 태스크에서, 이미지 확률변수를 x 라고 한다면 P(y|x) 은 정말 다양한 형태로 나타날 것이다

•

만약 싱글레이블이라면 [0, 0, 0, 0, 0, 1, 0, 0, 0, 0]

•

만약 멀티레이블이라면 [0, 1, 0, 0, 0, 1, 0, 0, 0, 1]

그리고 모델이 예측하는 값은 P(y|x:theta) 이다.

•

예를 들어 [0, 0, 0, 0, 0.9, 0.1, 0, 0, 0, 0]

•

또는 [0.1, 0.8, 0.3, 0.2, 0.9, 0.1, 0, 0, 0, 0]