안드레 카파시가 2017년무렵 테슬라에 와서 스마트서먼 기능 고도화를 위해 주행가능 영역 경계를 골라내는 occupancy tracker 개발을 주도하며 만들어낸 영상 처리 파이프라인을 짚어 보자.

1.

단일 2D 이미지(x8카메라,x1시퀀스 입력)(ref6) 를 받는다.

2.

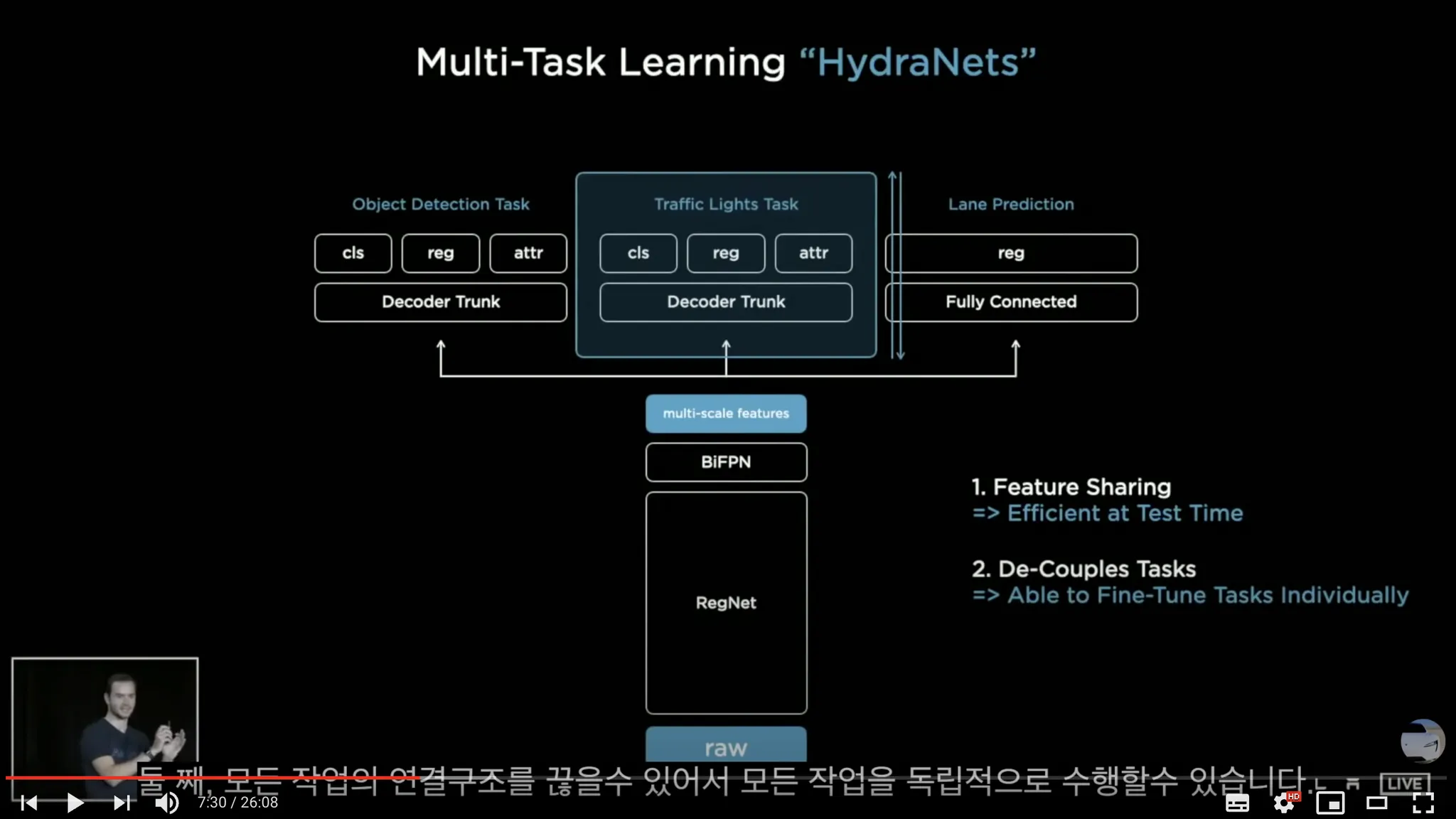

동일한 백본의 멀티태스킹 네트워크 "히드라넷"(ref7)에 통과시킨다.

그림(ref7)

3.

도로와 차선의 경계를 찾는 head 에서(x8카메라,x1시퀀스 입력) pixelwise classification을 이용해 2D 추론값(x8카메라,x1시퀀스 출력)을 수집한다. (발표에 나타난 그림과 설명을 종합해 볼 때 테슬라는 주행가능 영역을 segmentation으로 처리하는 대신, 도로의 경계(road edge)와 차선(road lane)정보를 segmentation 했다는 것을 알 수 있다)

하지만 단순히 곡선이나 직선을 피팅하는 방식이 아니라 경계를 segmentation 으로 처리하는 방식(pixel by pixel edge segmentation)(ref1:테슬라는 발표에서 "한 개의 픽셀로 이루어진 것이 아니다"라고 표현했다)에 더 가깝다(정확히 말하면, ‘에지 검출(detection)’이라고 표현하는 것이 더 맞지만, 흔히 ‘검출’은 바운딩 박스를 그려내는 작업이라는 점과 대비하여 segmentation의 의미를 살리고 싶었다).

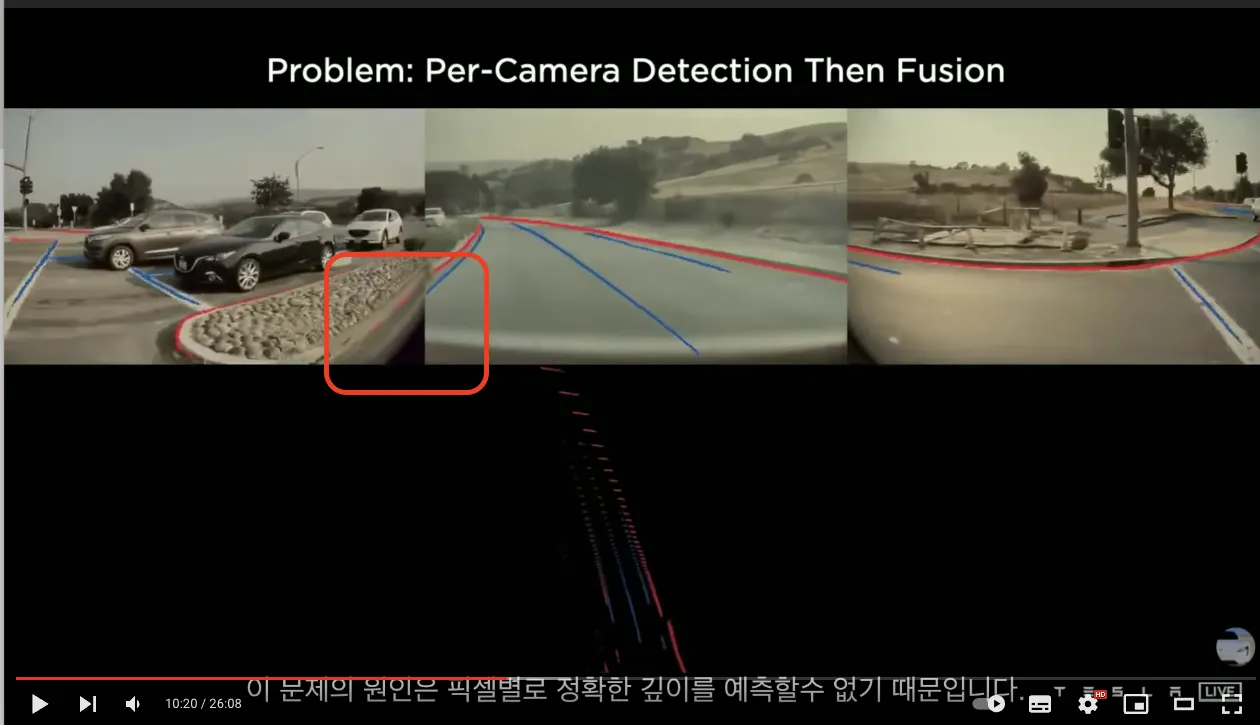

그림(ref1)

3D depth와 결합하면 화면의 아랫쪽 그림과 같이 선들이 끊기는 현상이 발생한다.

4.

마지막으로 2D 추론값(x8카메라,x1시퀀스)을 깊이(depth)정보(x8카메라,x1시퀀스)와 통합한다. 복잡한 하이퍼파라미터 튜닝을 통해 8개의 이미지를 잘 스티칭한다. 이를 바탕으로 주행가능영역을 생성한다. 2D 이미지 공간에서 segmentation 처리한 값을 3D 정보로 만들어주기 위해서 이러한 segmentaion 결과값과 depth prediction 결과와 합치려고 했다(ref2, ref5:pseudo-라이다 방식). 테슬라는 drivable area를 road edge segmentation 결과값으로부터 추정(ref3, ref4) 해내도록 했다. 이렇게 주행가능 영역을 처리하는 로직을 occupancy tracker 이라고 부른다.

5.

생성된 정보들 중 일부를 화면에 시각화한다(ref8).

parse me : 언젠가 이 글에 쓰이면 좋을 것 같은 재료들.

1.

None

from : 과거의 어떤 원자적 생각이 이 생각을 만들었는지 연결하고 설명합니다.

1.

•

2D segmentation 네트워크는 기존에 존재하던 것이었을 것이다. 여기에 3D 정보를 결합하는 방식으로 개발이 진행되음을 짐작해볼 수 있다.

supplementary : 어떤 새로운 생각이 이 문서에 작성된 생각을 뒷받침하는지 연결합니다.

1.

None

opposite : 어떤 새로운 생각이 이 문서에 작성된 생각과 대조되는지 연결합니다.

1.

None

to : 이 문서에 작성된 생각이 어떤 생각으로 발전되고 이어지는가?

ref : 생각에 참고한 자료입니다.

5.